计算机是怎样利用二进制来运行的?

最新回答

风中的歌声

2024-09-30 07:52:38

http://ced.xxjy.cn/Resource/Book/Edu/JSJCKS/TS003063/0003_ts003063.htm

乱世浮华つ

2024-09-30 03:03:01

以下举例,左边为十进制 右边为二进制

1 1

2 10(由于这里1往上加1就会出现2 所以直接进一位)

3 11

4 100(由于这里11往上加1就会出现12 所以直接进一位编程20 又出现2再进一位)

5 101

6 110

7 111

8 1000

9 1001

10 1010

这里十进制也是同理,9+1会出现十,所以往上进一位编程10这里读一零 二进制也都是读一与零

这样一举例 计算机内部的数字都是1和0组成 程序角度与计算机角度对比就是1代表是或对,0代表否或错

用电脑或其他电器的电源图标来看 有这样的⌽还有这个图标上面出头的 竖表示1,圈表示0,开机或接通电源就是1,关机或断电就是0

多普及一点儿 一般编程及程序里会发现 如果是二进制 想表达一个不算大的数字的时候太长了 而且文字也会被转化成各种编码 所以现在计算机软件层面的数据都是16进制的 编码大多数也已16进制与32进制为主

一下举例16进制

此行为十进制 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 ... 29 31 32

此行为16进制 1 2 3 4 5 6 7 8 9 A B C D E F 10 11 12 13 14 ... 1E 1F 20

果味小可爱

2024-09-30 15:36:33

西瓜小姐

2024-09-30 15:09:18

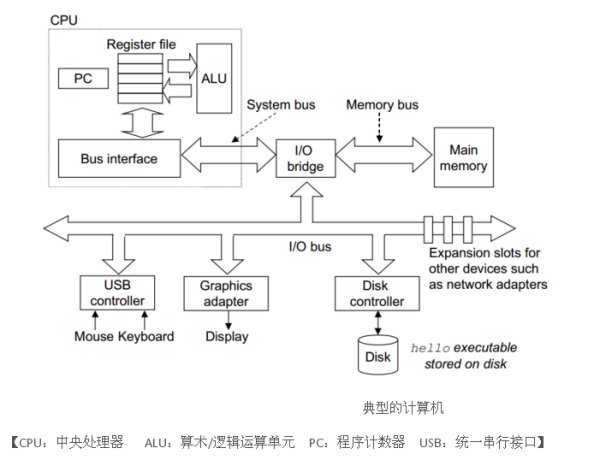

信息在计算机中都是用0或1表示的。计算机通过这些信息以及上下文来解读这些0/1,然后通过CPU进行处理。处理流程如下:

平胸小欧巴

2024-09-30 10:19:53

http://baike.baidu.com/view/18536.htm

热门标签