如何让 AI 生成的图片上显示指定文本?

2024-10-16 07:22:20

目前很流行的是让ai形成文本图画,我试了试

目前来看常用的Stable Diffusion 和 DALLE-2 还没有特意做文字生成这方面的训练,即使提出了类似要求,也很容易生成乱码或者扭曲的文字。但是使用图像编辑软件(如Adobe Photoshop、GIMP等),在生成的图片上添加文字。打开AI生成的图片,在编辑模式下,选择适当的工具(如文本工具),设置字体、大小、颜色等参数,然后在图片上添加指定的文本。就可以有效避免这个问题,新手党可以保存速冲。

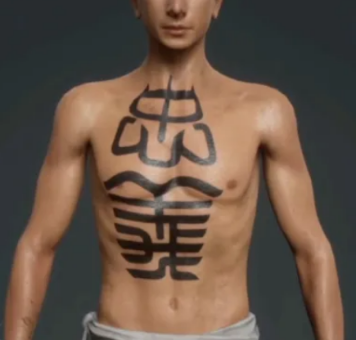

不过已经有很多人提出类似的需求了,比如想要在牌子、衣服上印特定的字,或者制作特定的文身、水印等等,这的确是有实际意义的。据说 Google 的 AI 会好一点,而且 NVIDIA 公开的 eDiff-I 已经有比较可用的结果了。

我觉得大概思路是使用文字生成模型,将需要显示的文本输入模型中,然后生成对应的图像。有一些开源的文字生成模型(如AttnGAN、StackGAN等)可以用于这个任务。

比如网友晒处的例子,常见的普通文本可以直接使用 wearing a T-shirt reads "some words" 尝试生成但是即便是使用这种方式,也很难定向设置字体/字号/样式等,如果是 Logo或者文身,最好还是用类似 PS 正片叠底叠加的方式,能整合

在 Stable Diffusion 里自动生成最好,整合不了也可以等大佬们直接做类似的插件功能。这种方法需要相关的算法和训练数据,机器学习技术可以帮助实现图像和文本之间的关联

。其实现在游戏捏人的时候有很多类似的做法,我印象很深的就是寅子的「忠义」,其实就是一个图片的叠加,绑定在人物建模上。至于有人提到用 controlNet 做,我初步想了想可能控制不了这么精细(也可能我钻研的还不够透彻…)。

目前 controlNet 提供的预处理模型及功能看模型描述最有希望的是 mlsd?但那玩意主要是用来检测建筑边缘的吧…还是得试试总之,我的想法是,对大佬们或者炼模型的人应该不难,我试着加入文字的训练,不过中文可能就不是很好了。

将来提 issue 的人多了可能会有更简便的模型或插件来实现,现在硬要找一些奇技淫巧有点太强求了。

2024-10-16 06:40:33

要让AI生成的图片上显示指定文本,可以尝试以下方法:

1. 图像编辑软件:使用图像编辑软件(如Adobe Photoshop、GIMP等),在生成的图片上添加文字。打开AI生成的图片,在编辑模式下,选择适当的工具(如文本工具),设置字体、大小、颜色等参数,然后在图片上添加指定的文本。

2. 文字生成模型:使用文字生成模型,将需要显示的文本输入模型中,然后生成对应的图像。有一些开源的文字生成模型(如AttnGAN、StackGAN等)可以用于这个任务。它们基于先前的训练数据和深度学习算法,可以将文本描述转化为图像。

3. 图文合成技术:利用图文合成技术,通过AI算法将指定的文本和图像进行融合生成新的图像。这种方法需要相关的算法和训练数据,机器学习技术可以帮助实现图像和文本之间的关联。

无论使用哪种方法,都需要借助相应的工具和技术来实现。具体的实现方式可能因使用的软件、模型或算法而有所不同。因此,在实践中,需要根据具体情况选择合适的工具和方法。

热门标签